metadata

base_model: unsloth/Meta-Llama-3.1-8B-Instruct-bnb-4bit

library_name: peft

datasets:

- aripos1/gorani_dataset

language:

- ko

- en

- ja

Gorani Model Card

소개 (Introduce)

이 모델은 번역을 위한 모델입니다. 한국 고유어의 정확한 번역을 생성하기 위해 한국어, 영어, 일본어의 언어 데이터를 혼합하여 unsloth/Llama-3.1-8B-Instruct-bnb-4bit을 학습시켜 생성된 gorani-8B 입니다.

gorani는 현재 한국어, 영어, 일본어만 번역을 지원합니다.

모델 정보

- 개발자: lucian1120

- 모델 유형: llama를 기반으로 하는 8B 매개변수 모델인 gorani-8B

- 지원 언어: 한국어, 영어, 일본어

- 라이센스: llama

Training Hyperparameters

- per_device_train_batch_size: 8

- gradient_accumulation_steps: 1

- warmup_steps: 5

- learning_rate: 2e-4

- fp16:

not is_bfloat16_supported() - num_train_epochs: 3

- weight_decay: 0.01

- lr_scheduler_type: "linear"

학습 데이터

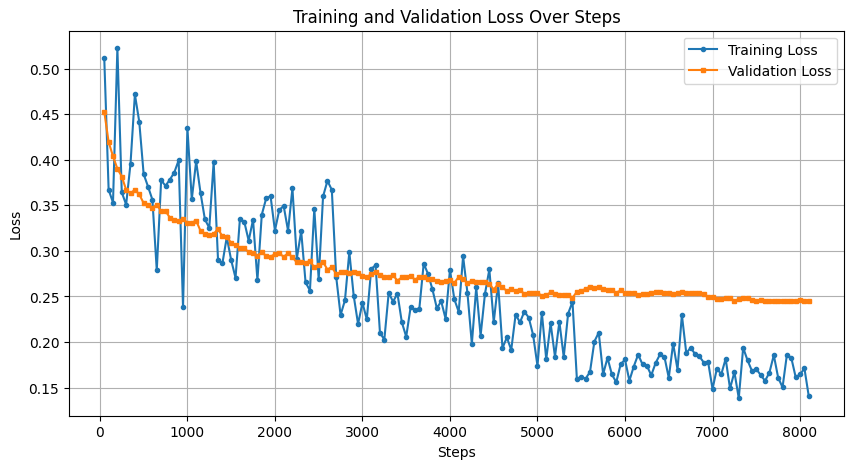

학습 성능 비교

![점수 비교 그래프]

📊 번역 평가 결과 비교

| 평가 지표 | LLama 3.1-8B | Gorani-8B |

|---|---|---|

| BERTScore (Precision) | 0.7123 | 0.8456 |

| BERTScore (Recall) | 0.6987 | 0.8621 |

| BERTScore (F1 Score) | 0.7055 | 0.8532 |

| COMET Score | 0.5902 | 0.8123 |