Wan2.1-Fun

Collection

5 items

•

Updated

•

2

😊 Welcome!

V1.0:

| 名称 | 存储空间 | Hugging Face | Model Scope | 描述 |

|---|---|---|---|---|

| Wan2.1-Fun-1.3B-InP | 19.0 GB | 🤗Link | 😄Link | Wan2.1-Fun-1.3B文图生视频权重,以多分辨率训练,支持首尾图预测。 |

| Wan2.1-Fun-14B-InP | 47.0 GB | 🤗Link | 😄Link | Wan2.1-Fun-14B文图生视频权重,以多分辨率训练,支持首尾图预测。 |

| Wan2.1-Fun-1.3B-Control | 19.0 GB | 🤗Link | 😄Link | Wan2.1-Fun-1.3B视频控制权重,支持不同的控制条件,如Canny、Depth、Pose、MLSD等,同时支持使用轨迹控制。支持多分辨率(512,768,1024)的视频预测,支持多分辨率(512,768,1024)的视频预测,以81帧、每秒16帧进行训练,支持多语言预测 |

| Wan2.1-Fun-14B-Control | 47.0 GB | 🤗Link | 😄Link | Wan2.1-Fun-14B视频控制权重,支持不同的控制条件,如Canny、Depth、Pose、MLSD等,同时支持使用轨迹控制。支持多分辨率(512,768,1024)的视频预测,支持多分辨率(512,768,1024)的视频预测,以81帧、每秒16帧进行训练,支持多语言预测 |

DSW 有免费 GPU 时间,用户可申请一次,申请后3个月内有效。

阿里云在Freetier提供免费GPU时间,获取并在阿里云PAI-DSW中使用,5分钟内即可启动CogVideoX-Fun。

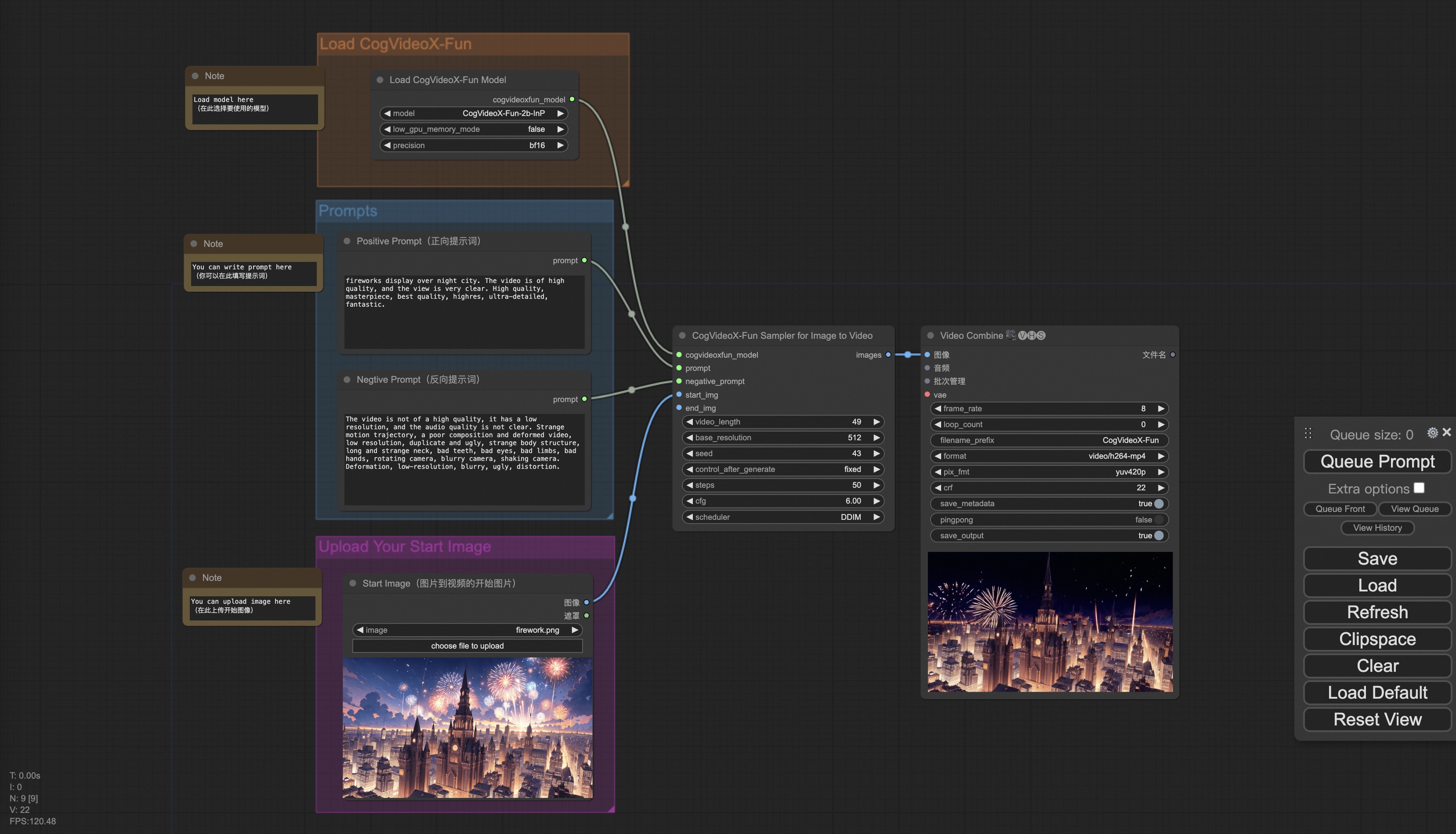

我们的ComfyUI界面如下,具体查看ComfyUI README。

使用docker的情况下,请保证机器中已经正确安装显卡驱动与CUDA环境,然后以此执行以下命令:

# pull image

docker pull mybigpai-public-registry.cn-beijing.cr.aliyuncs.com/easycv/torch_cuda:cogvideox_fun

# enter image

docker run -it -p 7860:7860 --network host --gpus all --security-opt seccomp:unconfined --shm-size 200g mybigpai-public-registry.cn-beijing.cr.aliyuncs.com/easycv/torch_cuda:cogvideox_fun

# clone code

git clone https://github.com/aigc-apps/CogVideoX-Fun.git

# enter CogVideoX-Fun's dir

cd CogVideoX-Fun

# download weights

mkdir models/Diffusion_Transformer

mkdir models/Personalized_Model

# Please use the hugginface link or modelscope link to download the model.

# CogVideoX-Fun

# https://huggingface.co/alibaba-pai/CogVideoX-Fun-V1.1-5b-InP

# https://modelscope.cn/models/PAI/CogVideoX-Fun-V1.1-5b-InP

# Wan

# https://huggingface.co/alibaba-pai/Wan2.1-Fun-14B-InP

# https://modelscope.cn/models/PAI/Wan2.1-Fun-14B-InP

我们已验证该库可在以下环境中执行:

Windows 的详细信息:

Linux 的详细信息:

我们需要大约 60GB 的可用磁盘空间,请检查!

我们最好将权重按照指定路径进行放置:

📦 models/

├── 📂 Diffusion_Transformer/

│ ├── 📂 CogVideoX-Fun-V1.1-2b-InP/

│ ├── 📂 CogVideoX-Fun-V1.1-5b-InP/

│ ├── 📂 Wan2.1-Fun-14B-InP

│ └── 📂 Wan2.1-Fun-1.3B-InP/

├── 📂 Personalized_Model/

│ └── your trained trainformer model / your trained lora model (for UI load)

由于Wan2.1的参数非常大,我们需要考虑显存节省方案,以节省显存适应消费级显卡。我们给每个预测文件都提供了GPU_memory_mode,可以在model_cpu_offload,model_cpu_offload_and_qfloat8,sequential_cpu_offload中进行选择。该方案同样适用于CogVideoX-Fun的生成。

qfloat8会部分降低模型的性能,但可以节省更多的显存。如果显存足够,推荐使用model_cpu_offload。

具体查看ComfyUI README。

webui支持文生视频、图生视频、视频生视频和普通控制生视频(Canny、Pose、Depth等)。当前该库支持CogVideoX-Fun、Wan2.1和Wan2.1-Fun,在examples文件夹下用文件夹名以区分,不同模型支持的功能不同,请视具体情况予以区分。以CogVideoX-Fun为例。

本项目采用 Apache License (Version 2.0).